Moderne Datenanalyse Gewinnen Sie wertvolle Erkenntnisse mit Leichtigkeit

Die Vorteile professionieller Datenanalyse

Inhaltsverzeichnis

1) Was ist Datenanalyse bzw. Datenauswertung?

2) Relevante Methoden und statistische Analyseverfahren

3) Überblick des Analyseprozesses in der Praxis

4) Vorteile & Funktionen moderner Datenanalyse Software

Weltweit schreitet die Digitalisierung rasant voran. Die digitalen Prozesse generieren in den Unternehmen riesige, täglich wachsende Datenmengen. Die Industrie 4.0 und das Internet der Dinge (IoT) beschleunigen diese Entwicklung zusätzlich. Um ein Unternehmen erfolgreich zu führen und die richtigen Entscheidungen zu treffen, sind detaillierte, tiefe Einblicke in die vielen verschiedenen Abläufe notwendig. Unternehmen stehen vor der Herausforderung, die vielen Daten zu aggregieren, sie zu verwalten und sie auszuwerten. Mit der Hilfe moderner Business Intelligence lassen sich Muster und Trends in den Daten finden und wichtige Informationen extrahieren. Die gewonnenen Erkenntnisse dienen als Basis für die Entscheidungs- und Führungsprozesse im Unternehmen. Führungskräfte und andere Stakeholder können fundierte, auf Daten basierende Entscheidungen treffen. Die Datenanalyse bietet entsprechende Lösungen zur Informationsgewinnung. Neben der Unterstützung der Entscheidungsprozesse dienen Datenauswertungen als Grundlage für zahlreiche weitere Anwendungen wie Zertifizierungen, Einhaltung von Compliance-Richtlinien, Erfüllung rechtlicher Vorgaben, Kontrollen, für regulatorische Zwecke und vieles mehr. Wichtigstes Ziel der Datenanalyse ist es, aus den vorhandenen Daten durch Anwendung verschiedener Methoden und Analyseverfahren die jeweils benötigten Erkenntnisse oder Informationen zu gewinnen. Im folgenden Beitrag erklären wir Ihnen, was unter Datenanalyse und Datenauswertung zu verstehen ist. Wir stellen Ihnen relevante Methoden und Verfahren für die statistische Analyse vor, beleuchten den Analyseprozess in der Praxis und bringen Ihnen abschließend die Vorteile moderner Datenanalyse Software wie datapine näher. Mit dieser Software können Sie selbst Daten auswerten und Analyseergebnisse visualisieren.

1) Was ist Datenanalyse bzw. Datenauswertung?

Die Begriffe Datenanalyse oder Datenauswertung beschreiben den Prozess, die für das Business benötigten Informationen aus Rohdaten zu gewinnen. Es kommen verschiedene Methoden und statistische Analyseverfahren zum Einsatz. Die gewonnenen Erkenntnisse werden in Form von Metriken und Datenvisualisierungen anschaulich dargestellt.

Auch wenn sich feine Unterschiede zwischen den Begriffen Datenanalyse und Datenauswertung finden lassen und einige wissenschaftliche Quellen die Begriffe in getrennten Definitionen beschreiben, in der Regel werden Datenanalyse und Datenauswertung in der Unternehmenspraxis synonym verwendet. Auch wir setzen in der folgenden Definition Datenanalyse und Datenauswertung gleich. Noch ein Hinweis vor der eigentlichen Definition der Datenanalyse: Häufig wird die Datenanalyse mit dem Data Mining gleichgesetzt. Das ist eigentlich nicht korrekt, da das Data Mining nur ein Teilbereich und Verfahren der Datenauswertung ist. Data Mining nutzt statistische Analyseverfahren, die sich in vielen Fällen der explorativen Datenanalyse zuordnen lassen.

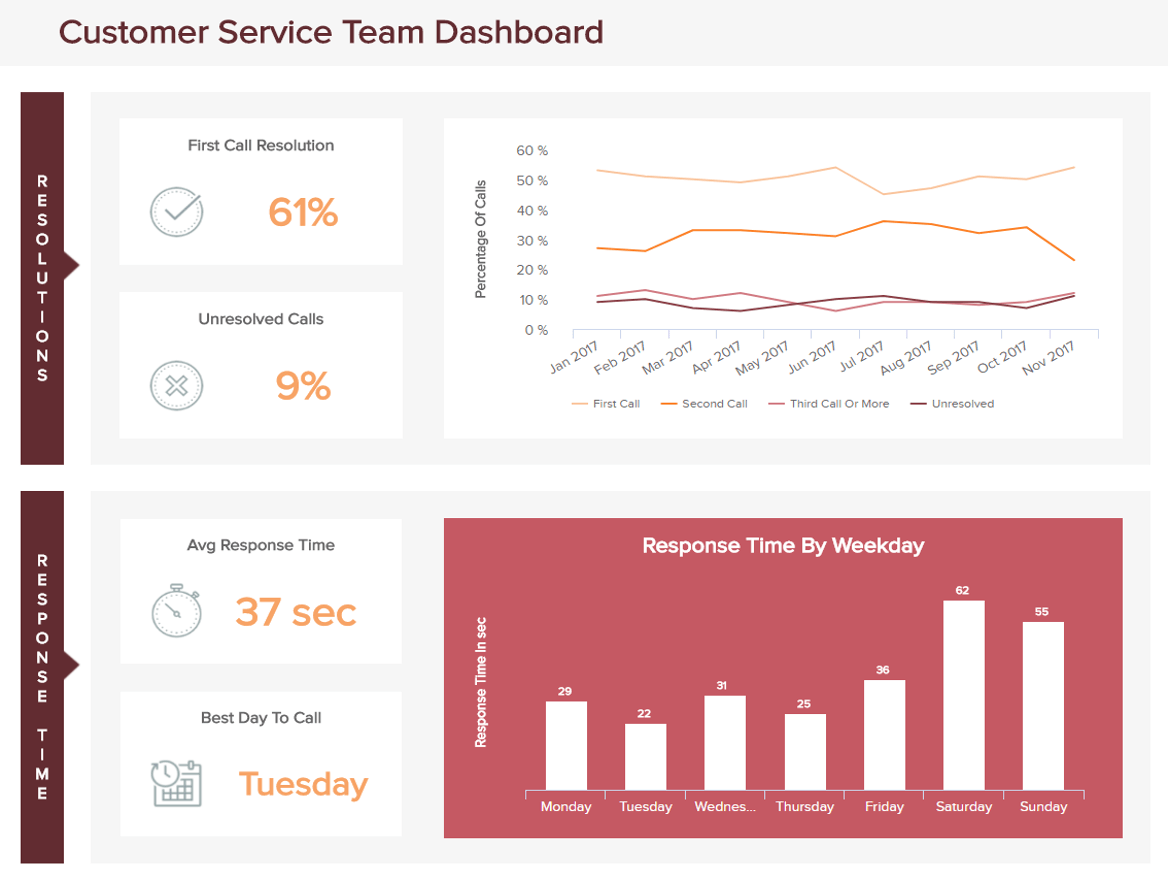

Doch nun zur Definition von Datenanalyse beziehungsweise Datenauswertung. Die Datenauswertung hat das Ziel, aus den vorhandenen Rohdaten unter Anwendung verschiedener Methoden und statistischer Analyseverfahren Informationen und Erkenntnisse zu gewinnen, sie zu beschreiben und darzustellen. Die statistische Auswertung ordnet und strukturiert die Daten. So können beispielsweise Muster oder Trends in den Daten gefunden werden. Die Methodik und die angewandten Verfahren werden durch die zu beantwortende Fragestellung und die Art und Qualität der Daten bestimmt. Datenauswertungen kommen in vielen Bereichen des täglichen Lebens zum Einsatz. Typische Anwendungen sind die Meinungsforschung, Analysen in der Wissenschaft, klinische Studien, das Reporting (Berichtswesen) in Unternehmen oder die Business Intelligence. Die durch die statistische Auswertung gewonnenen Erkenntnisse werden in Form von Zahlen, Fakten, Metriken oder Datenvisualisierungen wie Diagrammen dargestellt. Sie lassen sich über Reports oder Dashboards der jeweiligen Zielgruppe zur Verfügung stellen. In dieser Form unterstützen sie die Führungs- und Unterscheidungsprozesse des Unternehmens oder werden zur Erfüllung unterschiedlichster Anforderungen genutzt. Im unten dargestellten Dashboard zeigen wir Ihnen ein Praxis-Beispiel zur Präsentation der Ergebnisse einer Analyse des Kundenservices:

Die relevanten Methoden und statistischen Verfahren der Datenauswertung stellen wir Ihnen im nächsten Kapitel ausführlicher vor.

2) Methoden und statistische Analyseverfahren

Zur Einführung der Vorstellung der relevanten Methoden und Verfahren zur Datenauswertung möchten wir Ihnen zunächst kurz den Unterschied zwischen Business Intelligence und Business Analytics erläutern. Diese Unterscheidung hilft Ihnen die verschiedenen Methoden und Verfahren der Datenauswertung besser einzuordnen. Sowohl Business Intelligence als auch Business Analytics sind Datenmanagement-Lösungen, die die in einem Unternehmen anfallenden aktuellen und historischen Daten sammeln, sie analysieren und Einsichten in die verschiedenen Prozesse zur Unterstützung von Entscheidungsprozessen ermöglichen. Sie unterscheiden sich jedoch in ihrer Zielsetzung und der Art wie sie dies tun und welche Informationen sie bereitstellen.

Business Intelligence beschäftigt sich mit der Fragestellung: "Was ist in der Vergangenheit bis heute geschehen und warum ist es geschehen?". Die Business Intelligence findet Muster und Trends, zielt aber nicht darauf ab, die zukünftigen Entwicklungen vorherzusagen.

Business Analytics konzentriert sich auf die Fragestellung: "Warum ist etwas geschehen und was bedeutet das für die Zukunft?". Es werden die verantwortlichen Faktoren und kausalen Zusammenhänge für die Geschehnisse und Abläufe ermittelt. Diese nutzt Business Analytics, um Vorhersagen über zukünftige Entwicklungen zu machen.

Entsprechend der Unterscheidung von Business Intelligence und Business Analytics lassen sich die relevanten Analysemethoden in verschiedene übergeordnete Kategorien einteilen. Wir nehmen eine Unterteilung in diese fünf Kategorien vor:

die deskriptive Analyse

die explorative Analyse

die diagnostische Analyse

die prädiktive Analyse

die präskriptive Analyse

Beginnend bei der Kategorie der deskriptiven Analyse bis zur Kategorie der präskriptiven Analyse steigen Komplexität und Aufwand der Datenauswertung, aber auch der Mehrwert für das Unternehmen. Im Folgenden stellen wir Ihnen die fünf Kategorien näher vor.

a) Die deskriptive Datenanalyse

Die deskriptive Datenanalyse, auch als beschreibende Datenauswertung bezeichnet, konzentriert sich auf die Daten aus der Vergangenheit. Sie ordnet und strukturiert empirische Daten. Durch die Datenauswertung soll die Fragestellung beantwortet werden: "Was ist passiert?". Beispielsweise liefert sie Informationen wie den Umsatz im letzten Quartal oder die Art und die Anzahl von Serviceanfragen. Um diese Ergebnisse zu liefern, kann die deskriptive Analyse Daten aus verschiedenen Quellen extrahieren und die Informationen aggregieren, ordnen und strukturieren. Die deskriptive Analyse liefert aber keine Antworten auf Fragen wie: "Warum ist etwas geschehen?". Oft werden deskriptive Datenanalysen mit anderen Analysemethoden kombiniert.

b) Die explorative Datenanalyse

Ziel der explorativen Datenanalyse ist es, Zusammenhänge in Daten zu finden und Hypothesen zu generieren. Vor der explorativen Analyse existiert nur ein begrenztes Wissen über die Zusammenhänge der Daten und Variablen. Typischer Anwendungsbereich für die explorative Datenanalyse ist das Data Mining. Durch das Aufdecken von Zusammenhängen mit Hilfe der explorativen Datenanalyse lassen sich Rückschlüsse auf die Ursachen der Vorgänge ziehen.

c) Die diagnostische Datenanalyse

Die diagnostische Datenanalyse beschäftigt sich ganz konkret mit der Fragestellung: "Warum ist etwas geschehen?". Indem sie historische und andere Daten vergleicht, Muster identifiziert und Zusammenhänge aufdeckt, findet sie Ursachen oder gegenseitige Wechselwirkungen. Mit Hilfe der diagnostischen Datenanalyse können Unternehmen konkrete Problemstellungen lösen, da die Ursachen aufgezeigt werden.

d) Die prädiktive Datenanalyse

Die prädiktive Datenanalyse, auch als Vorhersageanalyse bzw. Predictive Analytics bezeichnet, gestattet den Blick in die Zukunft. Es wird die Fragestellung beantwortet: "Was wird passieren?". Um die richtigen Vorhersagen zu treffen, nutzt die prädiktive Datenanalyse die Ergebnisse der zuvor beschriebenen deskriptiven, explorativen oder diagnostischen Analysemethoden sowie Algorithmen und Methoden der Künstlichen Intelligenz (KI) und des Maschinellen Lernens (ML). Durch das Finden von Zusammenhängen, Ursachen und zeitlichen Tendenzen werden zukünftige Trends vorhersagbar. Die Vorhersagewahrscheinlichkeit und -genauigkeit hängen maßgeblich von der Qualität der Daten, den gefundenen Mustern, Zusammenhängen und Trends sowie von der Intelligenz der Algorithmen ab. Beispielsweise lassen sich zukünftige Umsätze vorhersagen oder das Kundenverhalten prognostizieren.

e) Die präskriptive Datenanalyse

Die präskriptive Datenanalyse ist die komplexeste und aufwendigste Analysekategorie. Sie liefert Unternehmen aber einen immensen Mehrwert, indem Sie die Fragestellung beantwortet: "Mit welchen Maßnahmen lassen sich Probleme beseitigen, zukünftige Entwicklungen positiv beeinflussen oder die gesetzten Ziele erreichen?". Präskriptive Datenauswertungen basieren auf historischen und aktuellen Daten interner und externer Datenquellen. Sie nutzen Ergebnisse zuvor beschriebener Analysekategorien. Die Vorhersagen werden kontinuierlich aktualisiert. Zum Einsatz kommen ML- und KI-Algorithmen, neuronale Netzwerke, Simulationen und Business Regeln.

Nachdem Sie die übergeordneten Kategorien der Analysemethoden kennengelernt haben, gehen wir im nächsten Abschnitt auf die für die Datenauswertung relevanten statistischen Analyseverfahren und Analysemethoden für Unternehmen ein. Wir beschränken uns auf die Beschreibung der folgenden sechs Verfahren zur statistischen Analyse:

1. Die Regressionsanalyse

Die Regressionsanalyse beschäftigt sich damit, wie sich der Wert einer abhängigen Variablen verändert, wenn einzelne unabhängige Variablen verändert werden, während andere unabhängige Variablen gleich bleiben. So zeigt sich, welche unabhängigen Variablen die untersuchte abhängige Variable beeinflussen und welche Zusammenhänge bestehen. In der Regel nutzt die Regressionsanalyse die statistische Auswertung historischer Daten. Sie erlaubt es, aus der Vergangenheit zu lernen, um bessere Entscheidungen für die Zukunft zu treffen. Typischer Anwendungsbereich sind Business-Vorhersagen beispielsweise, um auf Basis der Regressionsanalyse der erfassten Verkäufe, zukünftige Umsätze abhängig von bestimmten Marktgegebenheiten unter Zuhilfenahme prädiktiver Analyseverfahren vorherzusagen.

2. Die Kohortenanalyse

Die Kohortenanalyse untersucht und vergleicht das Verhalten verschiedener Personen über die Zeit und bildet Gruppen mit ähnlichen Eigenschaften oder Verhaltensweisen. Unternehmen können mit diesem Analyseverfahren beispielsweise Kundengruppen abhängig von demografischen oder anderen Merkmalen wie dem Kauf bestimmter Produkte bilden. Diese Kundengruppen lassen sich anschließend hinsichtlich des Kaufverhaltens vergleichen. So sind Rückschlüsse möglich, wie sich die Kundenqualität mit der Zeit verändert. Das Marketing kann die Ergebnisse beispielsweise mit den durchgeführten Kampagnen in Bezug setzen und deren Wirksamkeit überprüfen.

3. Die Clusteranalyse

Die Clusteranalyse erlaubt es, Datenelemente so zu gruppieren, dass sich die Elemente einer Gruppe hinsichtlich bestimmter Kriterien oder Variablen ähnlicher verhalten als Elemente einer anderen Gruppe. Diesen Vorgang nennt man auch Clustern. Verwenden lässt sich die Clusteranalyse, um zusätzlichen Kontext für Daten oder Trends bereitzustellen. Typischer Anwendungsbereiche ist die Bildung von Zielgruppen. Zielgruppen können beispielsweise bestimmte Kundengruppen sein, die die Clusteranalyse abhängig von den vorliegenden Daten zu Clustern zusammenfasst.

4. Die Faktorenanalyse

Die Faktorenanalyse reduziert eine Vielzahl an Einflussvariablen auf eine geringere Anzahl von Faktoren. Die resultierenden Faktoren zeigen weniger Wechselwirkungen untereinander und beinhalten die Informationen aus mehreren zusammenhängenden Variablen. Die Faktorenanalyse liefert ein mathematisches Modell, das sich zur Generierung von Hypothesen einsetzen lässt. Ein Anwendungsbeispiel für die Faktorenanalyse ist die Kundenbewertung eines Produkts anhand vieler verschiedener Kriterien. Die Bewertungskriterien lassen sich anschließend zu wenigen, für die Bewertung maßgeblichen Faktoren zusammenfassen. Dies erleichtert die Optimierung des Produkts, da nicht alle Kriterien einzeln, sondern nur die Faktoren betrachtet werden müssen.

5. Neuronale Netzwerke

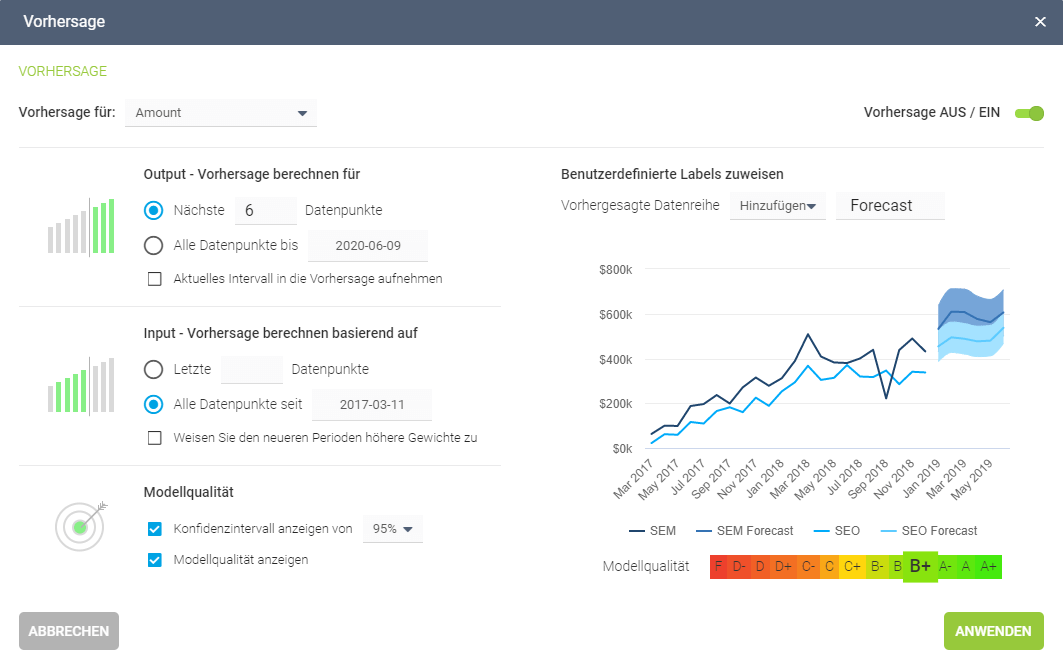

Typischer Anwendungsbereich künstlicher neuronaler Netzwerke ist die prädiktive Datenanalyse. Das neuronale Netzwerk bildet die Basis für die intelligenten Algorithmen des Maschinellen Lernens. Ziel ist es, die Entwicklung einer bestimmten Variablen vorherzusagen. Das neuronale Netzwerk ist der Funktionsweise des menschlichen Gehirns nachempfunden. Informationen fließen in mathematische Neuronen und werden von diesen verarbeitet. Die Ergebnisse leiten die Neuronen an die nächste Neuronen Ebene weiter, bis das Ergebnis von einem Output-Neuron ausgegeben wird. Es lassen sich Vorhersage-Engines realisieren, die exakte Prognosen liefern. Moderne Datenanalyse Software wie das Predictive Analytics Tool von datapine ermöglicht es Anwendern, Vorhersagen schnell und einfach zu generieren. Sie wählen die durch das Predictive Analytics Tool zu verarbeitenden Daten aus und die Software berechnet automatisch Prognosen basierend auf historischen und aktuellen Daten. Ein Beispiel für eine solche visualisierte Vorhersage-Engine von datapine sehen sie hier:

6. Das Data Mining

Das Data Mining wendet die explorative statistische Auswertung mit ihren verschiedenen Verfahren und Methoden auf große Datenmengen an. Ziel ist es, Abhängigkeiten, Zusammenhänge, Datenmuster und Trends zu identifizieren und dadurch Wissen zu generieren. Ein typisches Anwendungsbeispiel des Data Minings sind intelligente Datenalarme. Sie sorgen für das selbständige Erkennen von relevanten Mustern und Trends in Datenbeständen bzw. ausgewählter Key Performance Indicatoren (KPIs). Bei Anomalien oder Zielabweichungen, welche mit der Hilfe Künstlicher Intelligenz und Maschinellem Lernen automatisch identifiziert werden, erhalten Führungskräfte automatisch eine Benachrichtigung bzw. einen Alarm auf ihrem Dashboard.

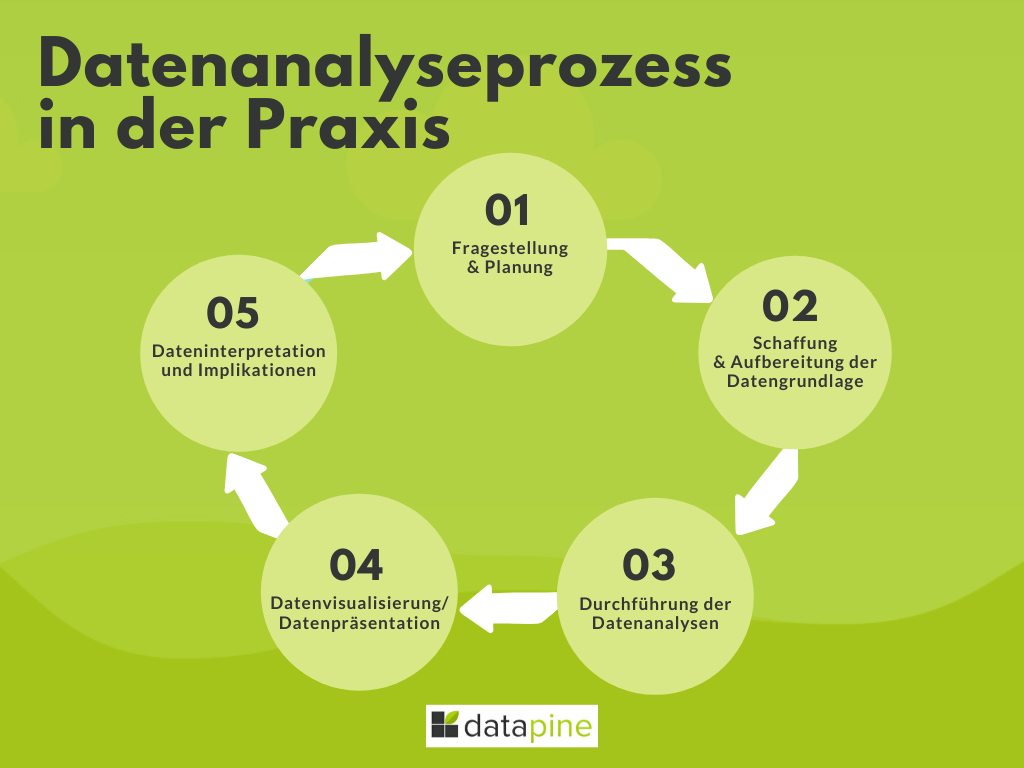

3) Der Analyseprozess in der Praxis

In der Praxis haben Analyseprozesse und die statistische Analyse ähnliche Abfolgen. Generell lässt sich der Analyseprozess in fünf aufeinander folgende Phasen einteilen:

Phase 1: Definition der Fragestellung und Planung der Analyse

In der Phase eins geht es zunächst darum, die von der Datenauswertung zu beantwortenden Fragestellungen zu definieren und die Analyse zu planen. Bevor Sie mit der eigentlichen Datenanalyse beginnen, setzen Sie sich mit Ihren Auftraggebern zusammen und legen Sie die Ziele für die Analysen fest. Ein Marketing Manager hat andere Ziele und ist auf der Suche nach anderen Antworten als ein Personalchef, ein Produktionsleiter oder eine CEO. Klären Sie für jede der Zielgruppen die individuellen Business-Ziele. Sinnvoll ist es, die Fragen konkret zu formulieren, deren Beantwortung zur Erreichung dieser Ziele notwendig sind. Sie können beispielsweise mit einem Brainstorming beginnen und die gefundenen Fragestellungen immer weiter präzisieren. Je spezifischer Ihre Fragen sind, desto spezifischer und wertvoller sind die Antworten. Stellen Sie daher nicht allgemeine Fragen wie: "Wie kann ich den Gewinn steigern?", sondern konkretisieren Sie die Frage beispielsweise so: "Auf welche Verkaufskanäle sollte ich mich für größere Gewinnmargen konzentrieren?". Oder noch besser: "Welche Marketing-Kampagne des letzten Jahres hatte den besten Return of Investment (ROI) und wie kann ich diesen Erfolg wiederholen?".

Überlegen Sie zur weiteren Planung der Datenauswertung anschließend, welche Daten oder Fakten sich nutzen lassen, um diese spezifischen Fragen zu beantworten. Haben Sie diese identifiziert, können Sie die nächste Phase beginnen und die benötigten Daten erheben oder aufbereiten.

Phase 2: Schaffung der Datengrundlage durch Datenerhebung, Datenaufbereitung und Datenqualitätssicherung

Lassen Sie uns jetzt zur nächsten Phase übergehen: Die Schaffung der Datengrundlage für Ihre Analysen. Sie haben in Phase eins die Daten und Fakten identifiziert, die Sie zur Beantwortung der definierten Fragen benötigen. Nun müssen Sie die Daten, falls noch nicht vorhanden, erheben oder bereits erfasste Daten aufbereiten. Für diesen Schritt legen Sie die Datenquellen fest, die die entsprechenden Rohdaten bereitstellen. Aus den Rohdaten müssen sich die relevanten KPIs für die Datenanalysefragen gewinnen lassen. Die KPIs sind notwendig, um Messwerte zu erhalten und Fakten zu bewerten. Beispielsweise möchten Sie die Frage beantwortet bekommen, welche Ihrer Marketingkampagnen erfolgreich waren. Der Erfolg lässt sich anhand verschiedener Key Performance Indikatoren wie Konversionsraten, Return of Investment (ROI), Anzahl neuer Kunden und anderer messen. Bestimmen Sie die relevanten KPIs zur Messung des Erfolgs. Zur Aufbereitung der Daten gehört es, sie in das richtige Format für die nachfolgende Datenanalyse zu bringen und nutzlose Daten auszuklammern. Alle Daten, die nichts mit den Business Zielen und den KPIs zu tun haben, sollten eliminiert werden.

Wesentlich für den Erfolg Ihrer Analysen ist zudem die Datenqualität. Die Daten sollten möglichst genau, vollständig, konsistent und zeitbezogen sein. Für eine hohe Datenqualität ist es sinnvoll, ein Data Quality Management (DQM) zu etablieren. Es beinhaltet alle notwendigen technischen und organisatorischen Maßnahmen und Strukturen zur Sicherstellung der Datenqualität. Ein DQM schafft die Basis für erfolgreiche Datenanalysen.

Phase 3: Die eigentliche Analyse der Daten (Durchführung der Datenanalyse)

In der dritten Phase erfolgt die eigentliche Auswertung der Daten. Statistische Analyseverfahren und Analysemethoden, wie in Punkt zwei beschrieben, werden angewandt. Die statistische Analyse erfolgt beispielsweise mit Hilfe von Regressionsanalysen, Kohortenanalysen, Clusteranalysen, Faktorenanalysen, Neuronalen Netzwerken oder Data Mining. Abhängig sind die angewandten Verfahren davon, ob Sie eine deskriptive Datenanalyse, explorative Datenanalyse, diagnostische Datenanalyse, prädiktive oder präskriptive Datenanalyse durchführen möchten. Oft sind mehrere Analyseverfahren und -methoden miteinander zu kombinieren, um die gewünschten Analyseergebnisse zu erhalten.

Eine besondere Form der Datenauswertung ist die sogenannte Adhoc-Analyse. Moderne Analyse Software und Self-Service BI wie von datapine erlaubt diese Art von Datenauswertung. Adhoc-Analysen werden für die Beantwortung einer ganz spezifischen Businessfrage direkt ausgeführt. Die Analyse lässt sich über eine Self-Service Oberfläche intuitiv von einem Business Anwender ohne spezifische oder technische Datenbankkenntnisse direkt zusammenstellen und ausführen. Sie liefert binnen kürzester Zeit die gewünschte Antwort. Die Antwort lässt sich anschließend, wie in der nächsten Phase beschrieben, visuell aufbereiten und in Dashboards oder Reports integrieren.

Phase 4: Die Datenpräsentation

Zur Beantwortung der Business Fragen der jeweiligen Zielgruppe sind die Ergebnisse der Datenauswertung zu visualisieren. Durch die Visualisierung lassen sich die Informationen im passenden Kontext darstellen und in eine Geschichte einbinden. Die Analyseergebnisse sind leichter vom Betrachter zu erfassen und zu verstehen. Gute Visualisierungen lenken den Betrachter auf die wichtigen Informationen und lassen die Antworten auf die gestellten Fragen oder die zu ergreifenden Maßnahmen direkt erkennen. Moderne BI Tools stellen zur Visualisierung der Datenanalysen interaktive, dynamische Dashboards bereit. Lassen Sie uns anhand der folgenden beiden Beispiele zweier mit datapine erstellter Dashboards die Vorteile dieser Art der Datenpräsentation genauer betrachten.

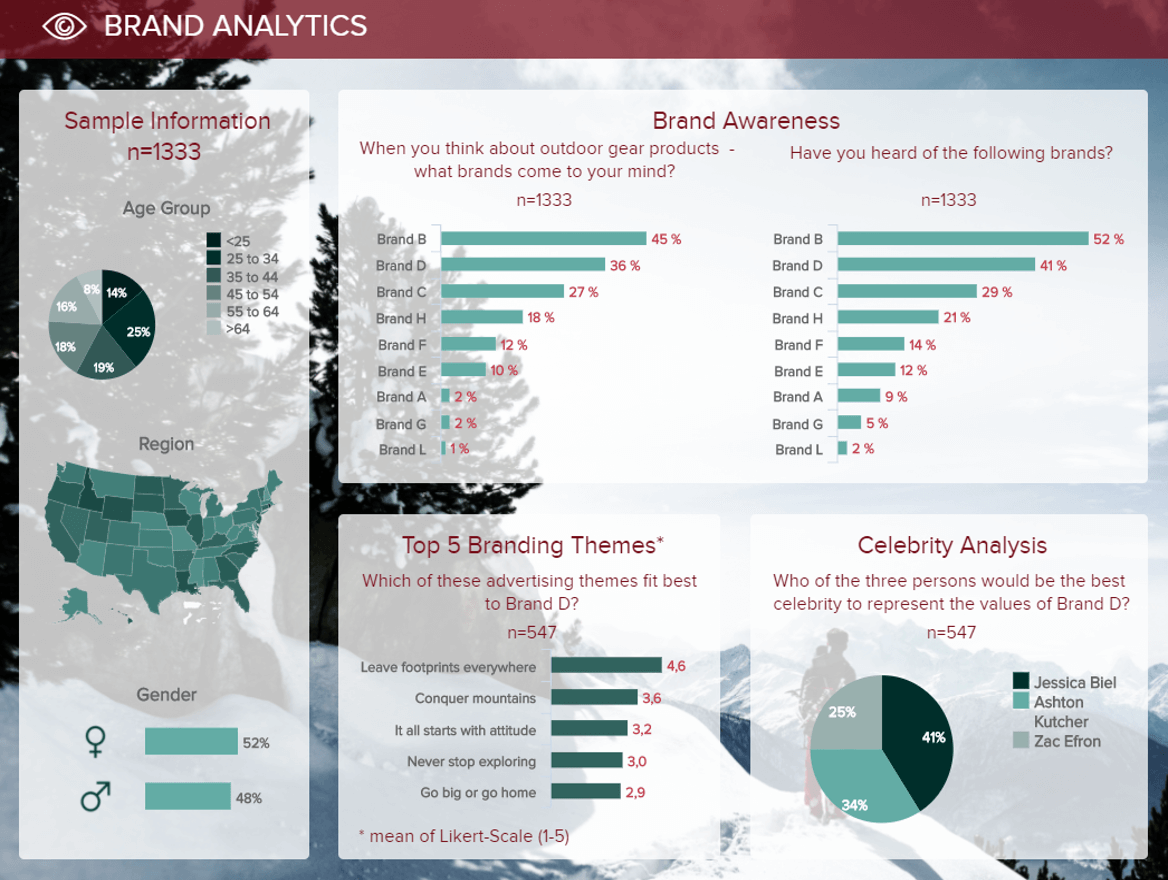

Beispiel 1: Das Markenbewusstsein Dashboard

Das Beispiel zeigt die Ergebnisse einer Umfrage zum Markenbewusstsein. Rechts sind demographische Merkmale der Befragten dargestellt wie Alter, Geschlecht und geographische Herkunft. Der obere Bereich des Dashboards gibt detailliert Auskunft über das Markenbewusstsein für verschiedene Marken. Die Grafiken visualisieren die Markenbekanntheit und die Markenwiedererkennung. Auf den ersten Blick ist zu erkennen, dass Marke B in beiden Kategorien die Spitzenposition einnimmt. Im unteren Bereich sind unterschiedliche Werbeslogans für die Marke D bewertet. Die größte Zustimmung findet der Slogan "Leave footprints everywhere". Rechts daneben sind die Umfrageergebnisse für den besten prominenten Werbebotschafter der Marke D dargestellt. Dank der interaktiven Funktionen lassen sich nicht nur die Ergebnisse für die Marke D, sondern auch für andere Marken im gleichen Dashboard zeigen.

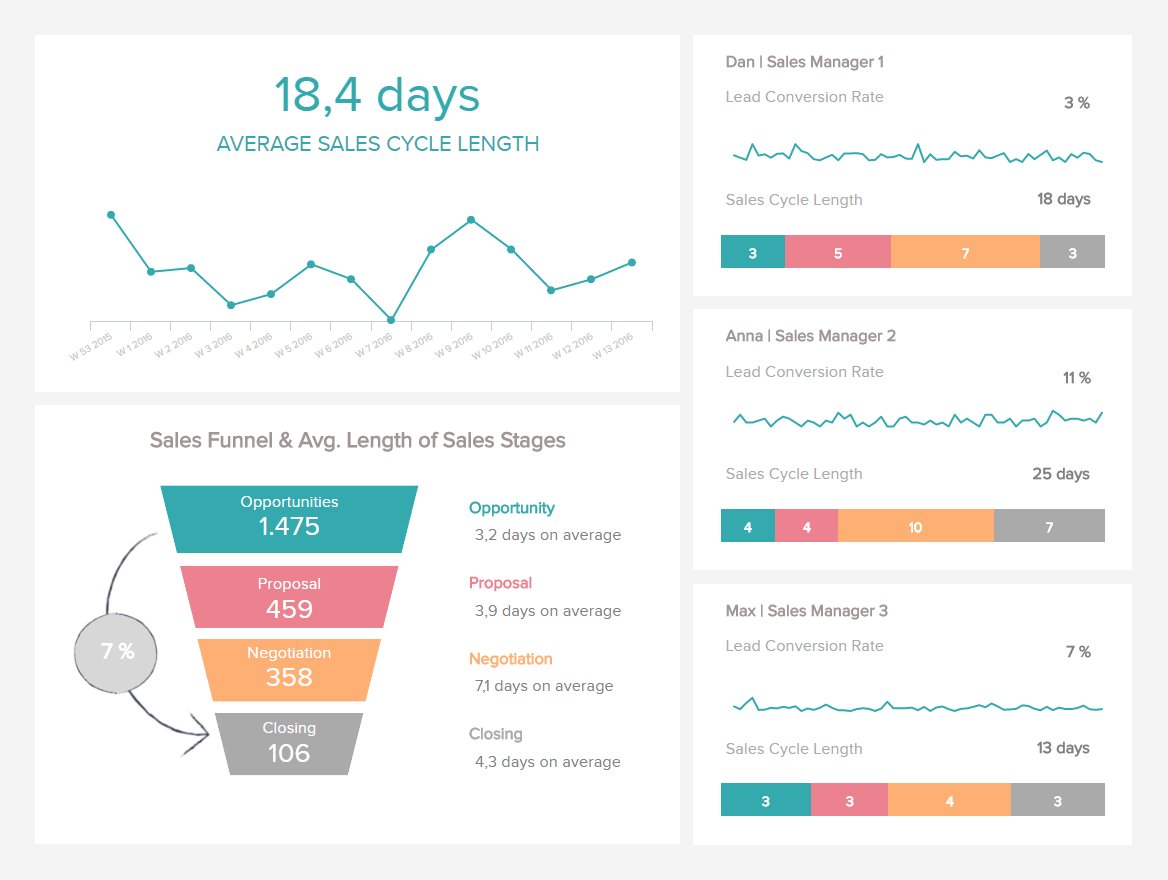

Beispiel 2: Das Verkaufszyklus Dashboard

Im B2B-Vertrieb ist die Verkaufszykluslänge einer der wichtigsten Vertriebskennzahlen. Je kürzer der Zyklus ist, desto besser ist die Vertriebsperformance, da wertvolle Sales Ressourcen eingespart werden. Interessenten verwandeln sich schneller in Kunden und generieren schneller Umsätze. Das dargestellte Verkaufszyklus Dashboard lässt sich mit der Dashboard Software von datapine mit wenigen Klicks zusammenstellen und zeigt durch die Analyse des Verkaufszyklus die Verbesserungspotentiale. Bis auf Mitarbeiterebene lassen sich die verschiedenen Vertriebsphasen genauer betrachten. Es ist erkennbar, ob einzelne Mitarbeiter oder Teams signifikant kürzere Verkaufszyklen haben. Entsprechende Maßnahmen zur Optimierung können aus den gezeigten Analyseergebnissen abgeleitet werden.

Phase 5: Die Dateninterpretation

Die letzte Phase des Analyseprozesses ist die Dateninterpretation. Die Dateninterpretation weist den Analyseinformationen eine Bedeutung zu und sorgt für die richtigen Schlussfolgerungen oder Konsequenzen. Ziel ist ein fundiertes, allgemein im Unternehmen anerkanntes Fazit aus den Analyseergebnissen abzuleiten. Letztendlich ist die Dateninterpretation der entscheidende letzte Schritt für den Erfolg der Analyse und muss sorgfältig durchgeführt werden. Dafür ist es notwendig, dass die visuelle Präsentation der Datenanalyse richtig verstanden wird. Mögliche Probleme, die bei der Dateninterpretation auftreten und den Erfolg der Datenanalyse zunichtemachen können, sind:

Korrelation vs. Kausalität: Häufig wird in der Unternehmenspraxis nicht sauber zwischen Korrelation und Kausalität unterschieden. Nur weil zwei Variablen eine hohe Korrelation haben, bedeutet dies nicht automatisch, dass diese auch eine Ursache-Wirkungs-Beziehung haben. Beispielsweise könnte eine latente, dritte Variable die eigentliche Ursache sein. Besonders in Zeiten von Big Data und Data Mining sollte dies beachtet werden und vermeintlich kausale Zusammenhänge inhaltlich geprüft werden.

Bestätigungstendenzen: Die sogenannte Bestätigungsneigung (confirmation bias) bezeichnet die menschliche Tendenz, Informationen so auszuwählen, zu suchen bzw. zu interpretieren, um die eigenen Erwartungen zu erfüllen. In der Unternehmenspraxis kann dies zu einem echten Problem werden, wenn der Analyst eine gewisses Hypothese oder Ergebnis im Sinn hat und nur Daten und Fakten berücksichtigt, die diese Hypothese stützen. Beispielsweise könnten die Ergebnisse durch das Ausschließen von vermeintlichen Ausreißern manipuliert werden. Aber dieses Phänomen tritt ebenso beim Betrachten der Analyseergebnisse auf, so dass kritische Ergebnisse ausgeblendet werden.

statistische Signifikanz: Gerade in der Unternehmenspraxis werden die Analyseergebnisse oft unzureichend hinsichtlich ihrer statistischen Signifikanz mit der Hilfe der entsprechenden Gütekriterien geprüft. Auch wenn im Vergleich zu beispielsweise klinischen Studien deutlich niedrigere Signifikanzniveaus notwendig sind, sollten diese bei der Interpretation der Daten immer berücksichtigt werden.

4) Vorteile & Funktionen moderner Software

Moderne Datenanalyse Software wie von datapine bietet Ihnen viele Vorteile und zahlreiche nützliche Funktionen. Mit Hilfe von modernen Tools können Sie selbst Daten auswerten und die Ergebnisse ansprechend präsentieren.

Mit professioneller Software lassen sich wichtige Fragen zur Performance des Unternehmens in kürzester Zeit beantworten und die Ergebnisse einfach mit anderen teilen. Hierfür stehen webbasierte Online Dashboards zur Verfügung. Datenauswertungen sind zu jeder Zeit, überall und mit beliebigen Endgeräten möglich. Cloudbasierte Services bieten besonders flexible Lösungen. Für die Datenanalysen sind keine spezifischen Datenbankkenntnisse wie SQL-Know-how notwendig. Die Analysen lassen sich von normalen Business-Anwendern durchführen. Hierfür bietet die Analyse Software grafische, intuitiv bedienbare Benutzeroberflächen. Auch nicht-technische Anwender haben dank dieser Benutzeroberflächen die Möglichkeit, komplexe Analysen einfach und schnell durchzuführen. Die Ergebnisse werden in interaktiven Dashboards präsentiert, die für die korrekte Interpretation der Analyseergebnisse sorgen und sich individuell anpassen lassen. Dashboard-Funktionen wie Drill-Downs, Zoom-Ins oder hierarchische Filter erlauben es bei Bedarf, tiefer in die Details vorzudringen, spezifische Daten zielgruppengerecht anzuzeigen oder sich einen schnellen Überblick zu verschaffen. So können die Analyseergebnisse mit einem einzigen Dashboard aus verschiedenen Perspektiven betrachtet werden.

Für die statistischen Analysen sind verschiedene Verfahren oder Methoden wie neuronale Netzwerke, Data Mining, Kohortenanalyse und Adhoc-Analysen nutzbar. Zur selbständigen Trendidentifikation und Erkennung von Mustern nutzt professionelle Software intelligente Algorithmen und ermöglicht automatische Datenalarme. Moderne Dashboards und Datenalarme erlauben die Automatisierung des aufwendigen Prozesses der Überwachung ausgewählter KPIs. Individuelle Alarme sind mit wenigen Klicks zusammengestellt. Die zu überwachenden Key Performance Indikatoren müssen nur ausgewählt und die gewünschten Intervalle für die Datenauswertung festgelegt werden. Anschließend überwacht die Analyse Software die Kennzahlen selbständig und informiert, wenn Schwellwerte überschritten oder Anomalien entdeckt werden. Intelligente, selbstlernende Algorithmen sorgen für optimierte, immer genauere Berechnungen und Prognosen. Bei Anomalien, Zielabweichungen oder Schwellwertüberschreitungen wird die zuvor definierte Zielgruppe automatisch informiert. Hierfür bietet moderne Software Informationskanäle wie E-Mails, in denen alle wichtigen Informationen und Kennzahlen in aggregierter Form dem Empfänger mitgeteilt werden. Die sofortige Alarmierung gestattet es, umgehend zu reagieren und die richtigen Maßnahmen einzuleiten. Um nicht nur Fragen zu beantworten: "Was ist passiert?", sondern vorherzusagen, was passieren wird, integriert moderne Analyse Software Funktionen wie das Predictive Analytics Tool von datapine, das mithilfe Künstlicher Intelligenz exakte Vorhersagen mit hoher Eintrittswahrscheinlichkeit trifft.

Eine weitere wichtige Funktion moderner Analysesoftware ist die schnelle und unkomplizierte Integration interner und externer Datenquellen. So lässt sich die Basis bereitstellen, auf der die Analyseverfahren die Daten auswerten. Zur Anbindung der Datenquellen stellt die Software eine Reihe von leistungsstarken Datenkonnektoren für unterschiedliche Datenbanksysteme, Datentypen und Schnittstellen zur Verfügung. Mit Hilfe der Konnektoren lassen sich verschiedene Datenbanksysteme unterschiedlicher Hersteller, Dateien, Cloud-Speicher und ERP- oder CRM-Systeme innerhalb weniger Minuten in die Analyse Software integrieren. Zur Anbindung von Cloud-Services und Drittanbietern sind APIs nutzbar. Die Konnektoren schaffen die Voraussetzung, alle relevanten Datenquellen in einer einzigen Analyse Plattform zusammenzuführen. Die Fragmentierung der Daten und die Trennung in einzelne Datensilos wird vermieden. Allen Anwendern im Unternehmen bietet die Analyse Software zentral eine konsistente Datenbasis.

In den verschiedenen Branchen und Unternehmensbereichen werden immer wieder ähnliche Analysen durchgeführt. Um das Rad nicht jedes Mal neu erfinden zu müssen, bietet moderne Analyse Software eine große Auswahl an Vorlagen. Diese lassen sich mit wenigen Klicks an die individuellen Analyseanforderungen anpassen und sind binnen Minuten einsatzbereit. Dank vorgefertigter Visualisierungen werden die Analyseergebnisse anschaulich präsentiert.

5) Zusammenfassung & Handlungsempfehlungen

In diesem Beitrag haben wir Ihnen erklärt, was Datenanalyse bzw. Datenauswertung ist. Wir haben Ihnen die übergeordneten Kategorien der Analysemethoden wie die explorative Datenanalyse oder die deskriptive Datenanalyse und andere vorgestellt. Anschließend sind wir im Detail auf einige ausgewählte Verfahren für die statistische Analyse eingegangen. Ausführlich haben wir die fünf verschiedenen Phasen des Analyseprozesses in der Praxis besprochen. Abschließend erhielten Sie einen Überblick über wichtige Funktionen und Vorteile moderner Analyse Software wie datapine.

Mit datapine haben Sie die Möglichkeit, eine professionelle Datenanalyse Software 14 Tage lang kostenlos zu testen. Sie können während dieses Testzeitraums selbst Daten integrieren, Daten auswerten, Analyseergebnisse visualisieren und sie mit anderen teilen. Überzeugen Sie sich davon, wie sinnvoll und nützlich die Datenauswertung auch für Ihr Unternehmen ist. Mit wenigen Klicks führen Sie binnen kürzester Zeit eigene Analysen durch. Mit Ihren Analysen schaffen Sie die Grundlage für fundierte Entscheidungen. Melden Sie sich jetzt kostenlos bei datapine für den 14-tägigen Test an und beeindrucken Sie Mitarbeiter oder Führungskräfte mit Ihren Datenanalysen!

Profitieren Sie von moderner Datenanalyse noch heute!